La Real Academia Sueca de Ciencias ha anunciado esta semana los premios Nobel de 2024. Los anuncios de los galardones en las categorías de Física y de Química han sorprendido por su relación con la inteligencia artificial, tanto en sus aspectos teóricos como en las aplicaciones.

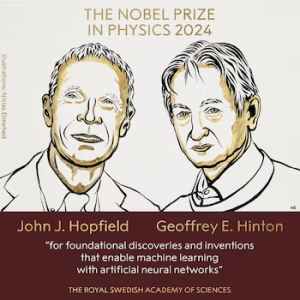

El premio Nobel de Física reconoce a John J. Hopfield (Princeton University) y Geoffrey E. Hinton (University of Toronto) por sus «contribuciones fundacionales e inventos que permiten el aprendizaje de las máquinas con redes neuronales artificiales».

Hopfield se preguntó en los años ochenta si los fenómenos colectivos emergentes en grandes colecciones de neuronas podrían dar lugar a capacidades “computacionales”. En 1982 describió un modelo dinámico de memoria asociativa basado en una red neuronal recursiva (Proc. Natl. Acad. Sci. USA 79, 2554 (1982)). La red de Hopfield, que guarda y recrea patrones, está basada en el concepto físico de espín atómico, una propiedad que convierte a cada átomo en un pequeño imán. El comportamiento global de la red es equivalente al comportamiento de la energía en los sistemas de espín que se estudian en física. El nuevo estado de cada nodo está determinado por la suma ponderada de los estados de los otros nodos. Estos pesos son simétricos y garantizan la estabilidad del sistema. Los estados estacionarios son las memorias que se almacenan de manera no local entre los nodos del sistema. Además se asigna una función monótona decreciente de energía del sistema, que también depende de los pesos y los estados de parejas de nodos. La red de Hopfield tiene propiedades de corrección de errores o capacidad de completar pratones. La red se entrena encontrando valores para las conexiones entre los nodos de modo que las imágenes guardadas tengan baja energía. Cuando la red de Hopfield recibe una imagen distorsionada o incompleta, trabaja metódicamente a través de los nodos y actualiza sus valores para que la energía de la red disminuya. De este modo, la red trabaja paso a paso para encontrar la imagen guardada que más se parezca a la imagen imperfecta con la que se la alimenta. Hopfield construyó un modelo análogico de su red en 1984 para comprobar que sus características no son un artefacto de su simple estructura binaria.

Geoffrey Hinton, junto Terrence Sejnowski y otros colaboradores, desarrolló una extensión estocástica de la red neuronal de Hopfield en 1985: la máquina de Boltzmann (Cognitive science, Elsevier, 9 (1): 147–169 (1985)). Esta máquina es un modelo generativo que se basa en la distribución estadística de los patrones. Puede aprender a reconocer elementos característicos en un tipo dado de datos gracias a herramientas de la física estadística. Contiene nodos visibles que correspondena los patrones a aprender y nodos ocultos adicionales para permitir el modelado de distribuciones de probabilidad más generales. Los pesos y los parámetros de sesgo de la red se determinan de modo que la distribución estadística de los patrones visibles generados por el modelo se desvíe mínimamente de la distribución estadística de un conjunto dado de patrones de entrenamiento. Hinton y sus colegas desarrollaron un algoritmo de aprendizaje basado en gradientes formalmente elegante para la determinación de parámetros. La máquina se entrena con ejemplos que es muy probable que surjan cuando se la utiliza. La máquina de Boltzmann se puede utilizar para clasificar imágenes o crear nuevos ejemplos del tipo de patrón con el que se la entrenó. Hinton se basó en este trabajo y contribuyó a iniciar el explosivo desarrollo actual del aprendizaje automático.

Hinton trabajó para Google en el desarrollo de la inteligencia artificial entre 2013 y 2023 pero renunció a este trabajo para tener libertad de alertar sobre los potenciales peligros de estos avances tecnológicos para la humanidad. Fue una de las firmas originales de la Carta abierta que proponía una moratoria de los experiemntos gigantes con inteligencia artificial el 22 de marzo de 2023. Hinton fue reconocido con Premios Fundación BBVA Fronteras del Conocimiento en la categoría de Tecnologías de la Información y la Comunicación en 2016 «por sus contribuciones pioneras y altamente influyentes» para dotar a las máquinas con la capacidad para aprender.

Nobel de Química

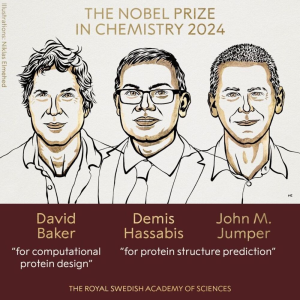

El premio Nobel de Química distingue a David Baker (University of Washington) por el diseño computacional de las proteínas y a Demis Hassabis (Google DeepMind) y John M. Jumper (Google DeepMind) por la predicción de la estructura de las proteínas.

Las proteínas son moléculas con una compleja estructura tridimensional y formadas generalmente a partir de una larga secuencia de aminoácidos. En 2003, David Baker logró diseñar una nueva proteína, a partir de los 20 tipos de aminoácidos que generalmente componen las proteínas conocidas, que no se parecía a ninguna proteína previamente conocida. Desde entonces, su grupo de investigación ha producido una imaginativa proteína tras otra, incluidas aquellas que pueden usarse como productos farmacéuticos, vacunas, nanomateriales y sensores diminutos.

El trabajo de Hassabis y Jumper supone un avance espectacular en un problema propuesto hace más de 50 años. Se trata de predecir las estructuras de las proteínas a partir de sus secuencias de aminoácidos. En 1972 recibió el premio Nobel de Química por sus trabajos en la desnaturalización y renaturalización de la ribonucleasa que le permitieron sugerir que toda la información requerida por la proteína para adoptar su configuración final está codificada en su estructura primaria. En 1994 comenzó la competición bianual Critical Assessment of Structure Prediction (CASP) con el objetivo de impulsar los avances en la comprensión de la estructura espacial de las proteínas.

Los científicos de Google DeepMind presentaron en 2021 AlphaFold, un innovador sistema de inteligencia artificial basado en redes neuronales, que ha sido capaz de resolver este problema de forma extremadamente barata y rápida y con exactitud a nivel atómico incluso sin el conocimiento previo de estructuras similares. Una segunda versión de AlphaFold compitió en CASP14, demostrando una precisión competitiva con las estructuras experimentales en la mayoría de los casos y superando con creces a otros métodos. Las predicciones de AlphaFold, disponibles gratuitamente a través de la base de datos de estructura de proteínas AlphaFold, han brindado a más de 2 millones de científicos e investigadores de 190 países una poderosa herramienta para realizar nuevos descubrimientos. El artículo AlphaFold2 (Nature volume 596, págs 583– 589 (2021)) se ha convertido en solo tres años en una de las publicaciones más citadas de todos los tiempos. Hassabis ha declarado: «Espero que consideremos AlphaFold como la primera prueba del increíble potencial de la IA para acelerar el descubrimiento científico».

Recordamos que David Baker, Demis Hassabis y John Michael Jumper ya recibieron el Premio Fundación BBVA Fronteras del Conocimiento en Biomedicina en su decimoquinta edición “por sus contribuciones al uso de la Inteligencia Artificial para la predicción exacta de la estructura tridimensional de las proteínas”.